大数据项目开发实践报告概述

本报告旨在总结和反思大数据项目的开发实践过程。我们深入探讨了大数据技术的核心概念、应用领域以及其在不同行业中的实际案例。通过实际操作,我们学习了如何使用Python进行数据处理和分析,并利用Scikit-Learn库构建了简单的机器学习模型。我们还研究了Hadoop生态系统中的主要组件及其工作原理,如HDFS和MapReduce。我们对整个项目的实施进行了评估,指出了取得的成果和存在的不足之处,并提出了一些建设性的改进建议。,,在本次实践中,我们不仅掌握了大数据技术的基本知识和技能,还培养了团队合作精神和解决问题的能力。我们也认识到大数据技术的发展前景广阔,未来将继续关注其最新动态和应用场景。

本文目录导读:

随着信息技术的飞速发展,大数据技术在各个领域中的应用越来越广泛,本文将详细介绍大数据项目的开发实践过程,包括项目背景、技术选型、实施步骤以及取得的成果。

一、项目背景与目标

在当今信息化时代,企业面临着海量数据的挑战,为了更好地利用这些数据,提高决策效率和业务创新能力,我们决定开展一项大数据项目,该项目旨在建立一个高效的大数据分析平台,通过整合和分析来自不同来源的数据,为企业提供有价值的信息和建议。

项目需求分析

我们对企业的现有系统和数据进行深入调研,了解其特点和需求,在此基础上,制定了详细的项目计划和时间表。

a. 数据源识别:

- 确定所有可能的数据来源,如数据库、日志文件、社交媒体等;

- 分析每种数据的特点和格式,以便后续的处理和分析。

b. 功能需求定义:

- 根据业务需求确定需要实现的功能模块,例如数据采集、清洗、存储、分析和可视化展示等;

- 设计相应的接口和服务,确保各部分之间的无缝对接。

技术选型

在选择合适的技术栈时,我们考虑了性能、可扩展性、安全性等因素。

a. 数据处理框架:

- 选择Apache Hadoop作为分布式计算的基础架构,因为它具有高吞吐量和容错能力;

- 采用Spark Streaming进行实时流式数据处理,以满足对时效性的要求。

b. 数据仓库解决方案:

- 使用Amazon Redshift构建数据仓库,它提供了强大的查询性能和易用性;

- 结合EMR(Elastic MapReduce)来处理大规模的数据导入导出任务。

c. 数据可视化工具:

- 利用Tableau或Power BI等商业智能软件进行数据报表的制作和发布;

- 自主开发前端界面,以适应特定的业务场景。

项目实施策略

为确保项目的顺利进行,我们采用了敏捷开发和持续集成的方法论。

a. 分阶段推进:

- 将整个项目划分为多个小型的迭代周期,每个周期结束后都会进行验收和质量检查;

- 通过频繁的沟通和反馈,及时调整计划和优先级。

b. 持续集成与自动化测试:

- 建立自动化的构建 pipeline,保证代码质量和稳定性;

- 实施单元测试和集成测试,覆盖主要功能点。

安全性与隐私保护措施

考虑到数据的安全性和合规性问题,我们在设计和实施过程中采取了多项安全措施。

a. 数据加密:

- 对敏感数据进行端到端的加密传输和处理;

- 在存储层面采用AES256位算法进行数据加密。

b. 访问控制与管理权限:

- 设置严格的身份验证机制,限制未经授权的用户访问系统资源;

- 根据角色分配不同的操作权限,遵循最小特权原则。

c. 日志审计:

- 记录所有的操作日志,便于事后追踪和分析;

- 定期审查日志记录,及时发现潜在的安全威胁。

二、项目实施过程

数据预处理阶段

在这一阶段,我们需要对原始数据进行清洗、转换和归一化处理,使其符合后续分析的规范和要求。

a. 数据去重与缺失值填充:

- 删除重复项和不完整的数据条目;

- 对于缺失值,根据具体情况选择合适的填补方法,如均值插补法或回归预测法。

b. 特征工程:

- 从原始特征中提取有用的信息,生成新的特征变量;

- 应用机器学习算法优化特征组合,提升模型的准确性。

数据存储与管理

为了有效地管理和利用大量数据,我们需要建立一套完善的数据管理系统。

a. 分布式文件系统搭建:

- 在HDFS上部署分布式文件系统,用于存储海量的非结构化数据;

- 配置副本因子和多路径读写策略以提高可靠性和性能。

b. 数据湖建设:

- 创建一个统一的数据湖环境,汇聚来自不同源头的异构数据;

- 实现数据的标准化和规范化,方便后续的分析和使用。

数据分析与挖掘

这一步是整个项目的核心环节,通过对数据的深度解析揭示隐藏的模式和价值。

a. 关联规则挖掘:

- 运用Apriori算法发现商品间的购买关联关系,指导营销策略制定;

- 利用FP-Growth算法进一步探索复杂的产品推荐逻辑。

b. 分类与聚类分析:

- 构建分类器模型识别客户群体并进行细分管理;

- 通过聚类算法找到相似度较高的客户簇群,为个性化服务奠定基础。

c. 时间序列预测:

- 采用ARIMA模型对未来一段时间内的销售趋势做出预估;

- 结合外部因素如节假日效应和市场波动影响进行更精准的判断。

结果呈现与应用落地

最后一步是将分析结果转化为直观易懂的报告形式,并应用于实际业务场景中。

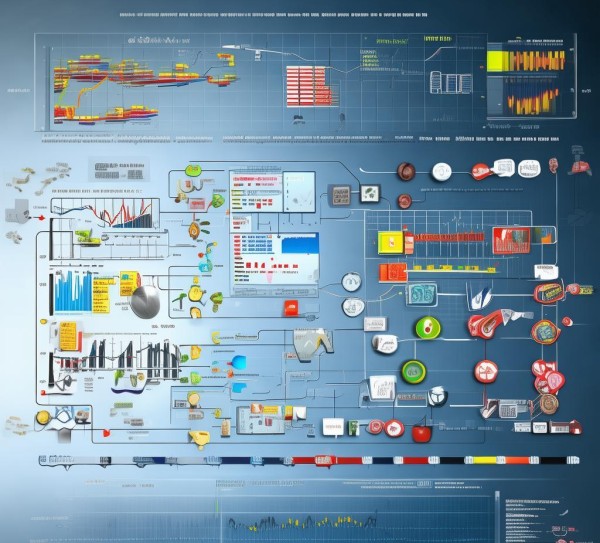

a. 可视化仪表板设计:

- 利用BI工具创建交互式的数据可视化图表,展示关键指标的变化情况;

- 设计

热门标签: #大数据项目开发实践报告 #数据分析技术