从零开始,大数据开发电脑组装与高性能工作站构建指南

本教程将全面介绍如何利用大数据技术进行高性能工作站的构建与优化。我们将从基础概念入手,逐步深入探讨大数据处理、存储、分析以及系统配置等关键环节,确保读者能够掌握搭建高效数据中心的各项技能。通过实际操作和案例分析,帮助您在实践中不断提升解决问题的能力,为未来的职业发展打下坚实基础。无论您是初学者还是有一定经验的IT人士,都能从中获得宝贵的知识和经验。

- [中央处理器(CPU)](#id1)

- [内存(RAM)](#id2)

- [存储](#id3)

- [显卡(GPU)](#id4)

- [电源供应器(PSU)](#id5)

- [操作系统](#id6)

- [数据库管理系统](#id7)

- [编程环境和工具链](#id8)

- [大数据框架](#id9)

- [系统监控与管理](#id10)

- [磁盘碎片整理与清理](#id11)

- [网络优化](#id12)

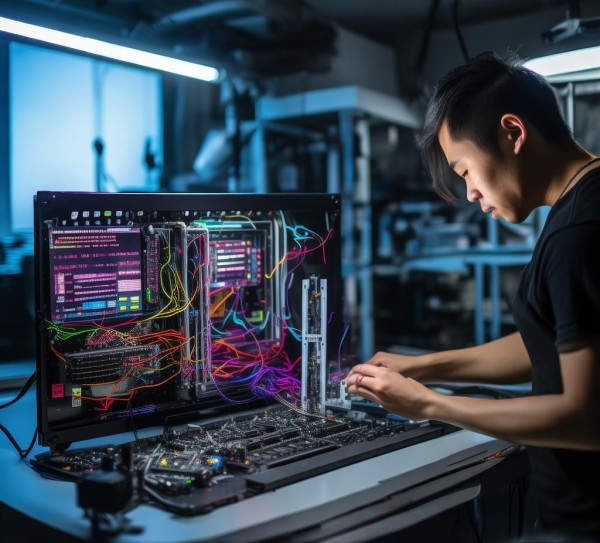

随着大数据时代的到来,对数据处理和分析的需求日益增长,为了满足这些需求,高性能的工作站成为数据分析、机器学习以及其他计算密集型任务的关键,本文将详细介绍如何组装一台适合大数据开发的计算机,包括硬件选择、软件安装以及优化设置等。

硬件选择与配置

中央处理器(CPU)

在构建大数据开发工作站时,选择一款强大的中央处理器至关重要,对于大多数大数据应用场景,Intel Core i7 或 AMD Ryzen 7 处理器都是不错的选择,这些处理器通常拥有多个核心和线程,能够处理大量的并发任务。

示例:

Intel Core i7-12700K:12核20线程,3.60GHz基础频率,5.10GHz睿频。

AMD Ryzen 7 5800X:8核16线程,3.80GHz基础频率,4.70GHz睿频。

内存(RAM)

充足的内存容量对于大数据开发非常重要,因为它可以减少磁盘I/O压力并提高应用程序的性能,建议至少配备32GB或64GB的高速DDR4 RAM,以支持多任务并行处理。

社区推荐:

Kingston HyperX FURY Beast DDR4 3200MHz CL16 16GB x2 Kit(总计32GB)

Corsair Vengeance LPX DDR4 3600MHz CL17 16GB x4 Kit(总计64GB)

存储

高速存储解决方案对于大数据开发至关重要,固态硬盘(SSD)提供了比传统机械硬盘(HDD)更快的读写速度,从而显著提升了系统响应时间和应用程序启动时间。

推荐选项:

Samsung 970 EVO Plus M.2 NVMe SSD:高达3500MB/s读取速度。

WD Black SN850 M.2 NVMe SSD:高达3400MB/s读取速度。

显卡(GPU)

虽然许多大数据任务主要依赖于CPU进行计算,但在某些情况下,如深度学习和图形处理,高端显卡可以加速特定类型的运算,NVIDIA GeForce RTX 30系列或AMD Radeon RX 6000系列显卡是不错的选择。

建议:

NVIDIA GeForce RTX 3080:具备强大的光线追踪能力和AI加速功能。

AMD Radeon RX 6900 XT:专为游戏和高性能计算设计的强大显卡。

电源供应器(PSU)

确保选择一个稳定且高效的电源供应器,以满足整个系统的电力需求,额定功率应高于所有组件的总功耗,同时考虑品牌信誉和质量保证。

选择标准:

Corsair RMx Series RM1000x:1000W全模块化电源,高效能和静音设计。

EVGA SuperNOVA P2 750W:750W金牌效率,适合中高负载环境。

软件安装与设置

操作系统

大数据开发工作站的操作系统可以是Windows、Linux或macOS,根据个人偏好和技术需求选择合适的操作系统。

Windows:

Windows 11 Pro:最新版本,具有先进的性能和安全特性。

Windows Server:适用于服务器环境的专用操作系统。

Linux:

Ubuntu:广泛使用的开源操作系统,社区支持和工具丰富。

CentOS:企业级发行版,稳定性极佳。

数据库管理系统

安装常用的数据库管理系统,如MySQL、PostgreSQL或MongoDB,以便于数据的存储和管理。

安装步骤:

1、从官方网站下载相应版本的安装包。

2、按照提示完成安装过程。

3、配置必要的参数和权限。

编程环境和工具链

安装Python、R或其他编程语言的集成开发环境(IDE),以及相关的开发工具链。

Python示例:

1、打开终端窗口。

2、输入pip install numpy pandas scikit-learn来安装常用库。

3、启动Jupyter Notebook或PyCharm等IDE进行编码。

大数据框架

部署Apache Hadoop、Spark等大数据处理框架,用于大规模数据的分布式处理和分析。

Apache Spark:

1、下载Spark的二进制文件。

2、解压到本地目录。

3、使用shell脚本启动集群服务。